Definiciones básicas de gestión de la innovación y control estadístico de procesos (Statistical Process Control, SPC)

Sinergia

La sinergia es el efecto combinado de factores, caracterizado por el hecho de que su efecto combinado excede significativamente el efecto de cada componente individual y su suma simple. Un estado de cosas generalmente expresado por la frase “el todo es mayor que la suma de sus partes”: 1+1=2x, donde x>1.

Aparición

La aparición (emergencia en inglés - aparición, aparición de algo nuevo) en la teoría de sistemas es la presencia en cualquier sistema de propiedades especiales que no son inherentes a sus subsistemas y bloques, así como a la suma de elementos no conectados por sistemas especiales de formación. conexiones; irreductibilidad de las propiedades de un sistema a la suma de las propiedades de sus componentes; sinónimo: “efecto sistémico”.

Aditividad

La aditividad es una propiedad de las cantidades con relación a la suma, consistente en que el valor de una cantidad correspondiente al objeto completo es igual a la suma de los valores de las cantidades correspondientes a sus partes: 1+1=2.

No aditividad

La no aditividad es lo opuesto al concepto de aditividad, una relación en la que el todo no está determinado por sus partes y el todo no puede ser conocido y explicado basándose únicamente en el conocimiento de sus partes (el todo es mayor o menor que el suma de sus partes): 1 + 1 = 2x, donde x < o > 1.

“La incapacidad de la dirección para comprender la interdependencia entre los componentes del sistema, combinada con la gestión por objetivos, provoca grandes pérdidas. Los esfuerzos de las distintas divisiones de la empresa que realizan su trabajo no cuadran: son interdependientes. Una división, en un esfuerzo por lograr sus objetivos, puede “matar” a otra división”.

Variabilidad

La variabilidad es variabilidad, incertidumbre, variedad, dispersión o una medida de desviación del "óptimo". El cambio en sí se llama variación o variante. Consulte el artículo para obtener más detalles: Naturaleza de la variabilidad .

Calidad de clase mundial

"¡El concepto de 'ajustar el objetivo con una variación mínima' ha definido la calidad de clase mundial durante los últimos treinta años! ¡Y cuanto antes hagas de este principio la regla de tu vida, más rápido te volverás competitivo!"

Ver la descripción Funciones de pérdida de Taguchi , explicando esta definición simple y sucinta de calidad de clase mundial.

Pensamiento estadístico

El pensamiento estadístico es un método para tomar decisiones basado en la teoría de la variabilidad sobre si intervenir o no en un proceso y, de ser necesario, a qué nivel.

“En primer lugar, si el resultado de un proceso está determinado por la influencia de causas especiales, entonces su comportamiento cambia de manera impredecible y, por lo tanto, es imposible evaluar el efecto de los cambios en el diseño, la capacitación, las políticas de adquisición de componentes, etc., que podrían ser introducido por la dirección en este proceso (o en el sistema que contiene este proceso) con el fin de mejorarlo. Mientras el proceso se encuentre en un estado incontrolado, nadie puede predecir sus capacidades.

En segundo lugar, cuando se han eliminado las causas especiales de modo que sólo quedan las causas generales de variación, las mejoras pueden depender de acciones de control. Dado que en este caso las variaciones observadas del sistema están determinadas por cómo y de qué manera se diseñaron y construyeron los procesos y el sistema, solo el personal de gestión, los altos directivos, tienen la autoridad para cambiar el sistema y los procesos.

Bueno, ¿cuál es la diferencia? ¿Y esto qué nos aporta? ¡Sí, todo lo que separa el éxito del fracaso!

En tercer lugar, llegamos al problema de que si no distinguimos (en la práctica) un tipo de variabilidad de otro y actuamos sin comprenderlo, no sólo no mejoraremos las cosas, sino que ciertamente las empeoraremos. Está claro que esto será así y seguirá siendo un misterio para aquellos que no comprenden la naturaleza de la variabilidad (variaciones)".

Grado razonable de control estadístico

“Dado que los gráficos de control están diseñados para detectar la falta de controlabilidad estadística, la presencia constante de un proceso dentro de los límites establecidos puede considerarse un indicador de controlabilidad estadística. Si nosotros, como Shewhart, consideramos el estado de controlabilidad estadística como un cierto ideal al que en la práctica sólo podemos acercarnos, entonces inevitablemente plantearemos la cuestión de un criterio que nos permita evaluar qué tan cerca está nuestro proceso de este ideal.

Cuando se aplica a gráficos de medias y rangos de un proceso que se describe utilizando subgrupos que constan de cuatro elementos, Shewhart propuso el siguiente criterio para la controlabilidad mínima: si al menos 25 subgrupos consecutivos no muestran signos de falta de control estadístico, entonces dicho proceso se considera que tiene un grado razonable de controlabilidad.

En su siguiente propuesta, Shewhart interpreta este criterio mínimo en términos del número total de observaciones presentes, por lo que puede adaptarse de la siguiente manera: cuando al menos 100 observaciones consecutivas no muestran pérdida de controlabilidad, se puede decir que el proceso exhibe un grado razonable. de control estadístico.

Al proponer un criterio de controlabilidad mínima, Shewhart enfatizó que existe una diferencia fundamental entre la ausencia de signos de incontrolabilidad y la conclusión de que el proceso se encuentra en un estado de controlabilidad estadística. La ausencia de signos de incontrolabilidad puede explicarse por las peculiaridades del intervalo de tiempo descrito en el mapa.

Las causas especiales pueden aparecer y desaparecer, y es posible que períodos relativamente cortos de observación no revelen puntos fuera de los límites de control. Sin embargo, cuantas más observaciones se acumulan que no revelan la presencia de causas especiales, mayor es la confianza en que el proceso se encuentra en un estado de control estadístico. Shewhart también señaló que uno puede estar prácticamente seguro de la controlabilidad de un proceso cuando no 100, sino 1000 mediciones consecutivas no revelan una falta de controlabilidad".

"Un fenómeno debe considerarse controlable cuando, utilizando la experiencia pasada, podemos predecir, al menos dentro de algunos límites, qué variaciones se pueden esperar en el futuro".

Enfoque científico y teoría del conocimiento de algo.

Ciclo del enfoque científico: estudio de los fenómenos observados - desarrollo de una teoría (suposición) que explica la observación y las definiciones operativas - predicción del comportamiento posterior de los fenómenos sobre la base de la teoría desarrollada, teniendo en cuenta los límites de aplicabilidad - verificación la conformidad de la siguiente observación con la teoría desarrollada: la confirmación de la teoría o su adaptación, o tal vez un rechazo total al desarrollo de una nueva teoría.

Un extracto del Sistema de conocimiento profundo (Elementos de la teoría del conocimiento) de Edwards Deming, que está directamente relacionado con la esencia del enfoque científico:

- Ningún número de ejemplos crea una teoría. Pero al menos un fracaso en una teoría requiere su revisión o incluso su abandono.

- Casi todas las acciones de gestión requieren predicción.

- Una declaración que no contiene una predicción no sirve de nada para un líder.

- Por definición, la predicción es imposible en un sistema inestable.

- La interpretación de los datos de una prueba o experimento es una predicción.

- Importancia definiciones operacionales , que dan a los conceptos un significado que puede transmitirse a otros.

- No existe un valor verdadero de ninguna característica, estado o condición que se determine mediante medición u observación.

El enfoque científico nos anima a tomar decisiones y formular políticas basadas en buena información, tanto cuantitativa como cualitativa, y no sólo en base a autopercepciones o consideraciones de corto plazo. A menudo implica analizar información utilizando métodos estadísticos (Control Estadístico de Procesos, SPC), pero también implica conocimiento y comprensión de las limitaciones de estos métodos, especialmente la conciencia de la importancia crítica de los fenómenos que no pueden describirse numéricamente. Deming cita a menudo a Lloyd Nelson, jefe del departamento de métodos estadísticos de Nashua Corporation:

"Los factores más importantes necesarios para gestionar cualquier organización normalmente se desconocen y no se pueden cuantificar".

No científico

Un signo importante de falta de cientificidad es la falta de poder predictivo.

“La teoría del conocimiento nos enseña que cualquier enunciado conlleva conocimiento cuando es capaz de predecir resultados futuros y corresponde a experiencias pasadas sin excepción alguna”.

Error del primer tipo (sobrerregulación)

El error del primer tipo (sobrerregulación) es la interpretación de las causas generales de las variaciones como especiales y, como resultado, una reacción ante cualquier evento que traspase los límites de tolerancia o no logre el objetivo planteado, en forma de un externo. acción correctiva (interferencia en el funcionamiento del sistema), introduciendo una variabilidad aún mayor.

Dibujo. Error del primer tipo (sobrerregulación)

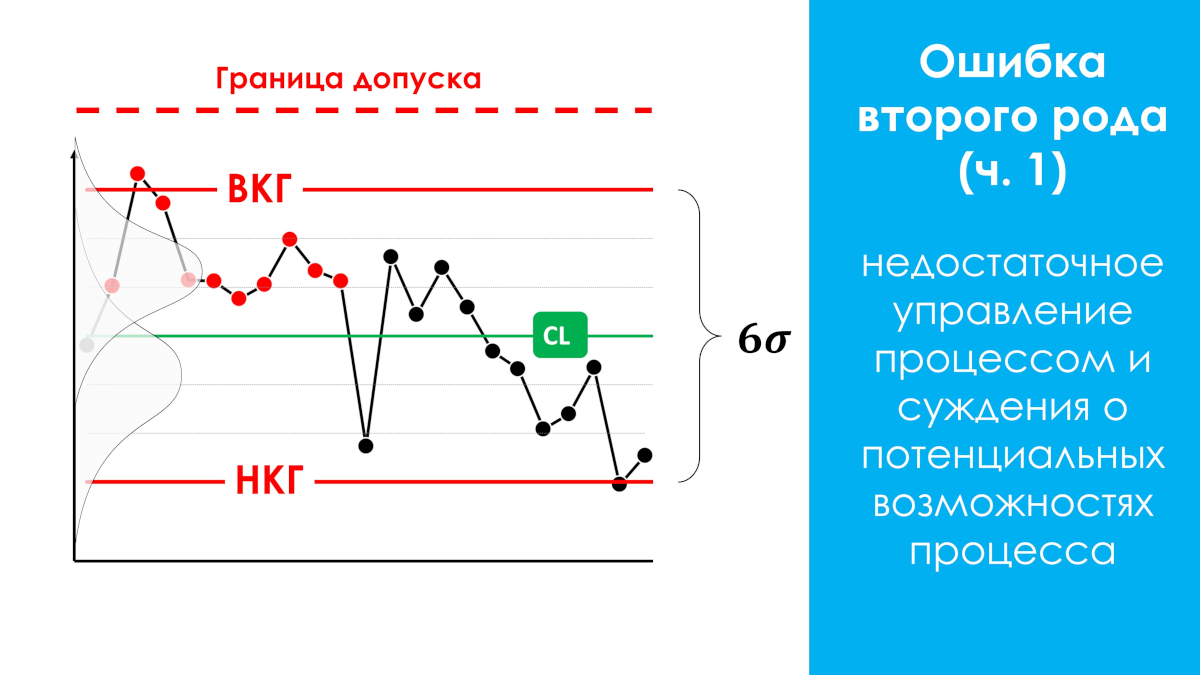

Error del segundo tipo (control de proceso insuficiente)

Error del segundo tipo (control insuficiente del proceso): juicios sobre las capacidades potenciales de un proceso que se encuentra en un estado estadísticamente incontrolable (incontrolado), porque tales juicios solo pueden aplicarse a procesos con predominio de causas comunes de variación, es decir, aquellos que se encuentran en un estado estadísticamente controlado. No tomar medidas para eliminar causas especiales si las variaciones provocadas por ellas entran dentro de los límites de tolerancia.

Dibujo. Error del segundo tipo (control insuficiente)

“¡Ambos errores son muy costosos! Cualquiera puede establecer una regla impecable para no cometer nunca un error del primer tipo.

Es muy sencillo: basta con conectar la variación en todos los casos con causas comunes. Sin embargo, esto maximiza las pérdidas por cometer un error de tipo 2. Y viceversa, al negarnos a cometer un error de tipo 2 al atribuir cualquier variación a causas especiales, aumentamos las pérdidas por un error de tipo 1.

Sería fantástico no cometer nunca errores ni del primer ni del segundo tipo, pero, lamentablemente, esto es imposible. Shewhart se fijó un objetivo completamente diferente: no tener miedo de cometer ambos tipos de errores, sino regular la frecuencia de estos errores de tal manera que se minimicen las pérdidas económicas de ambos. Como resultado, creó una herramienta: un gráfico de control con límites en el nivel 3x sigma. Desde entonces, su gráfico de control ha producido resultados sorprendentes en una amplia variedad de áreas de aplicación. ¡Realmente funciona!

El control estadístico se puede lograr buscando cada causa específica e identificándola cada vez que un punto queda fuera de los límites de control y tomando las medidas adecuadas".

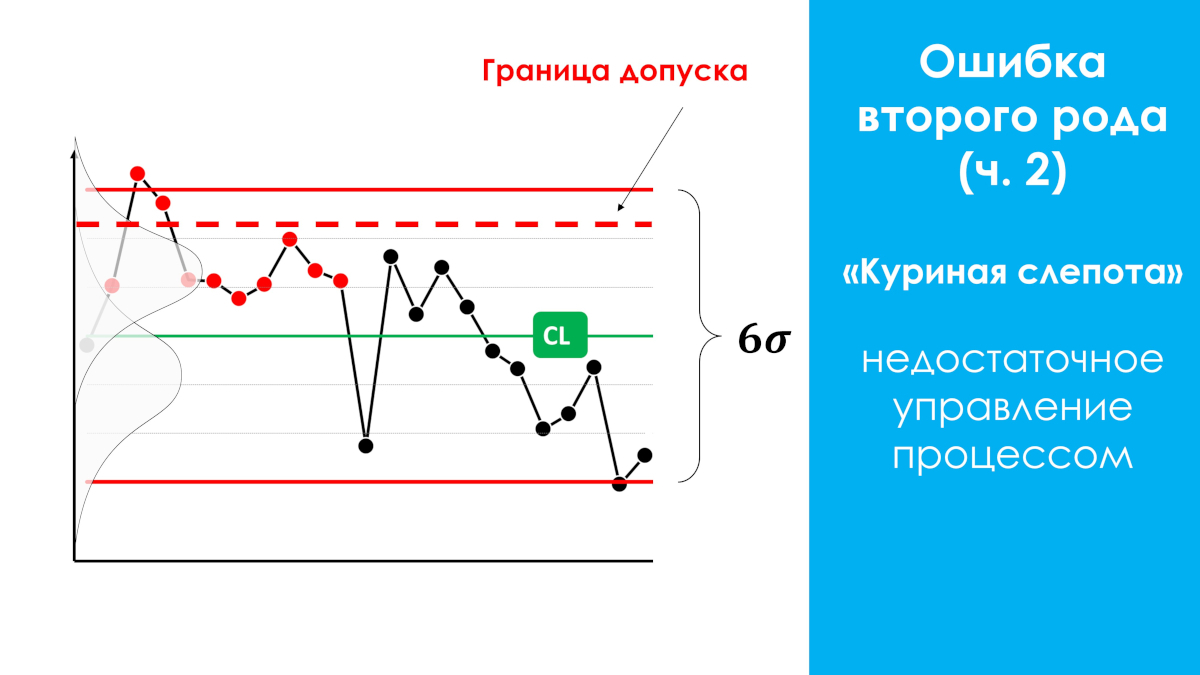

Error del segundo tipo, un caso especial (ceguera nocturna). Ocurre con mayor frecuencia.

Si el proceso que produce un producto defectuoso en relación con los límites de tolerancia se encuentra en un estado estadísticamente incontrolable (ver figura a continuación), intervenir en el proceso cuando algunos valores están fuera de los límites de tolerancia puede tener algún efecto positivo en el proceso. producción, pero siempre es ineficaz (esfuerzo-resultado), ya que existe una alta probabilidad de que se pasen por alto causas especiales de incontrolabilidad, que podrían identificarse mediante el gráfico de control de Shewhart en puntos, pero que se encuentran dentro de la zona de tolerancia, lo que conduce a "noche". ceguera” de los observadores: no aprovechar oportunidades adicionales para mejorar el proceso.

La ceguera nocturna es el fenómeno más común. Este caso especial de error de tipo II no ha sido explicado por separado hasta ahora en fuentes científicas rusas y extranjeras. En 2021, el director científico de nuestro centro AQT, S.P. Grigoryev, dio una descripción y un nombre a este caso especial.

Dibujo. Error tipo II, caso especial (ceguera nocturna)

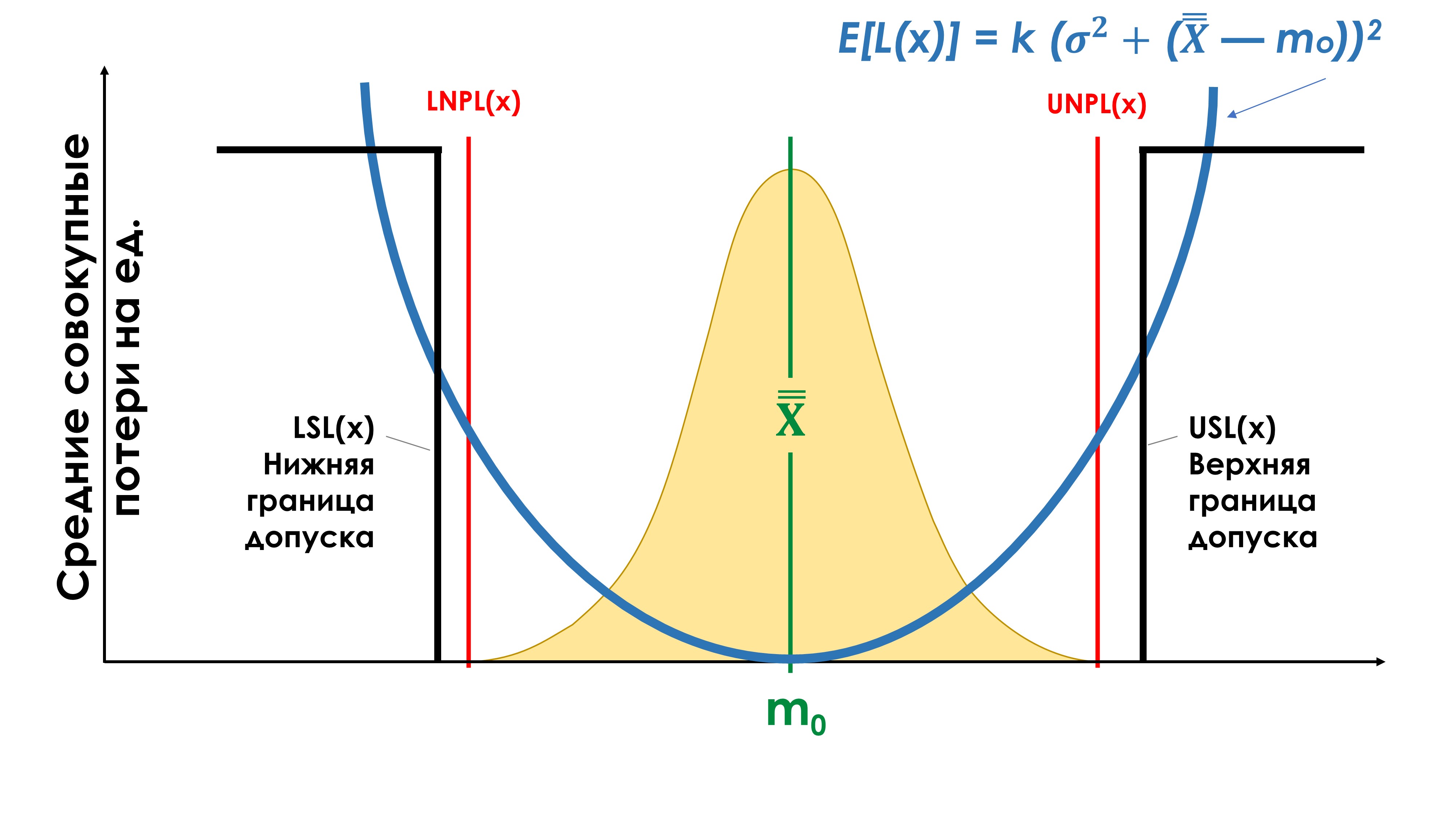

Función de pérdida de calidad de Taguchi

El científico japonés Genichi Taguchi propuso un nuevo enfoque para evaluar la calidad de los productos. La idea tradicional de la calidad del producto es que todos los productos fabricados son de igual calidad si sus indicadores (o parámetros) de calidad cumplen con los requisitos de la documentación técnica, que define la tolerancia para estos indicadores (parámetros). En otras palabras, dentro de la zona de tolerancia las pérdidas de calidad son cero. Si los indicadores de calidad superan los límites de tolerancia (LSL) y (USL), las pérdidas de calidad se declaran inaceptables. Taguchi llamó a esta función de pérdida de calidad (ver la figura a continuación, una línea recta discontinua) una "función discontinua similar a un umbral".

"De la función de Taguchi se desprende claramente que cumplir los requisitos de tolerancia no es de ninguna manera un criterio suficiente para juzgar la calidad. El intento de hacerlo está en clara contradicción con la insistencia en la mejora continua, uno de los principios fundamentales de la filosofía de Deming. De hecho, el último de los enfoques se caracteriza por una búsqueda constante en la dirección de mejorar la calidad, mientras que el primero no proporciona ningún incentivo para trabajar mejor una vez que los requisitos de tolerancia ya se han satisfecho.

Por el contrario, la ética subyacente de algunos enfoques establecidos de la calidad, incluidas las metodologías del costo de la calidad, tiende a desalentar nuevos esfuerzos de mejora basándose en que, si las necesidades del cliente han sido satisfechas, se requiere una mayor inversión de tiempo, esfuerzo y gastos en ese proceso en particular. no está justificado. ".

“El uso de tolerancias (especificaciones, especificaciones técnicas, especificaciones técnicas) no es un error. Simplemente no es suficiente”.

"El concepto del Dr. Taguchi, basado en el análisis de la función de pérdida, conduce inevitablemente a una nueva definición de calidad de clase mundial: ¡justo en el objetivo con una variación mínima! El primer requisito - 'justo en el objetivo' - significa que la media del proceso se establece de manera que que esté lo más cerca posible del objetivo (nominal). El segundo requisito, “varianza mínima”, significa que el proceso debe tener un grado razonable de control estadístico.

El incumplimiento del principio de “de acuerdo con el objetivo con una variación mínima” conducirá inevitablemente a un aumento significativo de las pérdidas promedio por unidad de producción. Estas pérdidas pueden ser muy graves, pero siempre innecesarias.

El “Cumplimiento de la Tolerancia”, el “Cero Defectos”, la “Calidad Seis Sigma”, el “Costo de la Calidad” y todos los demás medicamentos basados en la tolerancia simplemente no pueden satisfacer este principio. ¡El concepto de “ajuste fino al objetivo con una variación mínima” ha definido la calidad de clase mundial durante los últimos treinta años! ¡Y cuanto antes hagas de este principio la ley principal de tu vida, más rápido te volverás competitivo!

La aplicación del enfoque de calidad resultante de la función Taguchi debe aplicarse cuando se utilizan otros indicadores de calidad con límites "desde" y "hasta", por ejemplo, plazos de entrega según el contrato, etc.

Sistema de medición

Un sistema de medición es el resultado de la interacción entre el instrumento de medición utilizado, el método de medición, el entorno y el operador.

Cada operador de máquina que mide una pieza durante su fabricación es parte de su propio sistema de medición, que tiene su propia incertidumbre (variabilidad, error), sesgo y puede estar en un estado estadísticamente controlado (estable) o no controlado (impredecible). Un sistema de medición que se encuentra en un estado estadísticamente incontrolable es inútil. El sistema de medición de los controladores es otro sistema de medición. Cuando el operador envía sus productos para inspección, determina si cumplen con las tolerancias a través de su exclusivo sistema de medición. La evaluación y coherencia de los sistemas de medición debe realizarse antes de monitorear los procesos de trabajo.

¿Has acordado tus sistemas de medición con tus proveedores y clientes?

Genichi Taguchi

Genichi Taguchi (nacido en 1924) es un conocido estadístico japonés de la segunda mitad del siglo XX. Desarrolla las ideas de la estadística matemática, relacionándolas en particular con los métodos estadísticos de diseño experimental y control de calidad. Taguchi fue el primero en conectar los costos económicos y la calidad con una relación matemática, introduciendo el concepto funciones de pérdida de calidad . Fue el primero en demostrar que también se producen pérdidas de calidad dentro del rango de tolerancia.

En nuestra opinión, la falta de atención a los métodos de Taguchi es una de las razones del grave retraso de las empresas rusas en el ámbito de la mejora de la calidad de los procesos y productos.

Peter Scholtes

Peter Scholtes (1938-2009), uno de los consultores y educadores más famosos en el campo de los métodos de gestión de la calidad en Occidente, desarrolló las ideas del Dr. Deming. Lea el capítulo: El método de "gestión por objetivos": ¿qué pasa? Del libro “Team Handbook” de Peter Scholtes [7].

Sitio web de Peter Scholtes: www.pscholtes.com

Walter Andrew Shewhart

Walter Andrew Shewhart (Walter A Shewhart, 1891-1967), nacido en New Canton, pc. Illinois en 1891. Graduado de la Universidad de Illinois. Posteriormente se doctoró en física por la Universidad de California (1917).

En 1931, Shewhart publicó un informe sobre el uso de gráficos de control y su primer libro, Gestión Económica de la Calidad Industrial. 1939 se convirtió en una fecha especial en la biografía del profesor Shewhart de la Universidad de Rutgers. Luego se publicó su segundo libro [9] “Método estadístico desde el punto de vista del control de calidad”. Al final de la década, Shewhart resumió los resultados del trabajo sobre el método estadístico para monitorear la calidad de los procesos productivos y tecnológicos y garantizar, sobre esta base, la calidad de los productos manufacturados. El primer maestro y amigo más antiguo de Edwards Deming.

Donald J. Wheeler

Donald J. Wheeler es un consultor estadístico que tuvo la suerte de trabajar con David Chambers de 1970 a 1989.

Desde 1971, Wheeler ha enseñado control estadístico de procesos, primero a estudiantes de la Universidad de Tennessee y luego a gerentes industriales de todo el mundo.

Desde mediados de los años 1970 trabaja activamente como consultor.

En 1974, Donald Wheeler asistió por primera vez a las conferencias del Dr. Deming y siguió siendo su alumno para siempre.

A partir de 1981, ayudó en ocasiones a Edwards Deming a dirigir sus seminarios de cuatro días. Su propia filosofía de mejora de procesos se basa firmemente en la filosofía de Deming. Donald Wheeler es autor o coautor de seis libros y más de 60 artículos sobre control de procesos estadísticos.

Tuvo la oportunidad de trabajar con una amplia variedad de empresas industriales en todo el mundo. Da conferencias tanto en los Estados Unidos como en el extranjero.

Donald Wheeler recibió su licenciatura en física y matemáticas de la Universidad de Texas en Austin y su maestría y doctorado de la Universidad Metodista del Sur.

De 1970 a 1982 enseñó en el departamento de estadística de la Universidad de Tennessee. En 1982, Wheeler dejó la docencia para centrarse en la consultoría en la industria y otras áreas. Donald Wheeler vive actualmente en Knoxville, Tennessee.

El Dr. Donald J. Wheeler es miembro de la Asociación Estadounidense de Estadística y de la Sociedad Estadounidense para la Calidad, recibió la Medalla Deming en 2010 y es una de las principales autoridades mundiales en control de procesos estadísticos y análisis de datos aplicados.

Coautor de un libro superventas [4] "Control estadístico de procesos. Optimización empresarial mediante gráficos de control de Shewhart" / "Comprensión del control estadístico de procesos". Del prólogo de Edwards Deming a ese libro:

“Es un gran honor para mí escribir el prólogo del libro de mi amigo el Dr. Donald Wheeler.

...

En conclusión, me gustaría aprovechar esta oportunidad para elogiar los logros matemáticos del Dr. Wheeler. Su comprensión de la teoría y la práctica se basa en una profunda comprensión de las matemáticas. Y estoy feliz de tener la oportunidad de aprender de él".

Donald Wheeler, autor de numerosos artículos en publicaciones científicas sobre el uso de los gráficos de control de Shewhart en la industria, amablemente nos proporcionó algunos de ellos, los tradujimos al ruso y los publicamos en nuestro sitio web en la sección:

conocimientos fundamentales

.

Lista de artículos originales:

[9], [19], [20], [21], [25], [26], [29], [31], [33], [34], [35]

-Donald Wheeler.

David S. Cámaras

David S. Chambers (1917-1989) fue un amigo cercano y colega del Dr. William Edwards Deming y un consultor y profesor de control de procesos estadísticos de renombre internacional.

Fue miembro, presidente y presidente de la junta directiva de la Sociedad Estadounidense de Control de Calidad (ASQC), recibió el Premio Eugene Grant y académico de la Academia Internacional de Calidad. Una lista de sus colegas y antiguos alumnos podría servir fácilmente como ¿Quién es quién? en el campo del control de calidad.

David Chambers nació en Clarksville, Texas. Obtuvo su licenciatura y maestría en la Universidad de Texas, donde enseñó de 1941 a 1947 antes de convertirse en profesor asistente de estadística en la Universidad Estatal de Tennessee. Aquí trabajó como profesor de estadística de 1958 a 1981, tras lo cual se jubiló, lo que le permitió concentrarse en la docencia. Según el Dr. Deming, la pérdida de una persona así es irremplazable.

Myron Tribus

Myron Tribus, director de Exergy, dividió su tiempo entre Exergy Corporation, una empresa pionera en nuevos enfoques para la generación de energía, y su trabajo como consultor de gestión de calidad.

Con treinta años de experiencia como docente, también se desempeñó como Subsecretario de Ciencia y Tecnología en el Departamento de Comercio de Estados Unidos.

Fue vicepresidente senior de Xerox Corporation y director del Centro para la Excelencia en Ingeniería. Myron Trybus fue un seguidor del Dr. Edwards Deming. Lea el artículo de Myron Trybus Teoría viral de la gestión. donde establece una analogía con la medicina del siglo XIX (XIX) y la gestión del siglo XX (XX) para ilustrar por qué la sociedad se adhiere a los paradigmas dominantes y se resiste al cambio para mejorar nuestras vidas.

Henry R. Neave

Henry R. Neave. El Dr. Henry Neave conoció a Edwards Deming a mediados de la década de 1980 e inmediatamente se convirtió en su amigo íntimo. Desde entonces ha ayudado continuamente a Deming en sus seminarios de cuatro días en Europa, así como en otros seminarios, conferencias y eventos celebrados a ambos lados del Atlántico.

Fue Deming quien animó a Neave, como experto reconocido en la filosofía de Deming, a leer el libro [1] "El espacio del Dr. Deming: principios para construir una empresa sostenible". El propio Edwards Deming escribió el prólogo de este libro.

Es mejor empezar a estudiar la teoría de la gestión de Edwards Deming con este libro.

En 1987, por iniciativa del Dr. Neave, se organizó la Asociación Británica Deming, en la que Neave ocupa actualmente el cargo de director de educación. Durante muchos años, el Dr. Neave enseñó estadística en la Universidad de Nottingham en Inglaterra. Desde 1996 ha sido profesor de gestión a tiempo completo en el Departamento de Calidad de la Universidad de Trent, Nottingham.

Alfie Kohn

Alfie Kohn es un psicólogo social de renombre internacional. Vea en nuestro sitio web materiales elaborados con las obras de Alfie Kohn en los artículos: Sistema de motivación del personal. , El atractivo equivocado de la competencia .

Sitio web personal de Alfie Kohn: www.alfiekohn.org